что такое cuda ядра

Что такое ядра CUDA и как они улучшают компьютерные игры?

Когда вы выбираете новый графический процессор, вы, вероятно, встретите нечто, называемое «ядрами CUDA», в списке спецификаций графического процессора. Вы услышите, как люди в восторге от этих загадочных ядер, но вы до сих пор не представляете, как они улучшают GPU. Для вас они просто то, что заставляет вас думать о морском существе.

Это все изменится. Мы расскажем вам об основах ядер CvA от Nvidia и о том, как они помогают вашему ПК лучше воспроизводить графику.

Что такое ядра CUDA?

Ядра CUDA звучат круто, но они, к сожалению, не имеют ничего общего с барракудой. CUDA расшифровывается как «Compute Unified Device Architecture», которая мало что объясняет, что конкретно делают ядра CUDA. Эти высокотехнологичные ядра фактически специализируются на параллельной обработке. Другими словами, они способны работать вместе, чтобы выполнить задачу.

Вы знакомы с тем, как работают процессоры?

Что такое процессор и что он делает?

Что такое процессор и что он делает?

Вычислительные сокращения сбивают с толку. Что такое процессор в любом случае? И нужен ли мне четырехъядерный или двухъядерный процессор? Как насчет AMD или Intel? Мы здесь, чтобы помочь объяснить разницу!

Прочитайте больше

? Вы, наверное, знаете, что процессоры поставляются с ядрами. Некоторые имеют двухъядерные, четырехъядерные или даже поставляются с восемью ядрами. Все эти ядра помогают процессору обрабатывать данные — чем больше ядер, тем быстрее процессорные процессы.

Ядра CUDA работают так же, как и ядра ЦП (за исключением того, что они находятся внутри графических процессоров). Хотя вы обычно можете подсчитать количество ядер ЦП на обеих руках, количество ядер CUDA в графическом процессоре может исчисляться сотнями или тысячами. Как правило, вы не увидите GPU только с одним ядром CUDA — у GPU обычно их сотни и более.

Поскольку ядра CUDA намного меньше, чем ядра ЦП, вы можете разместить больше из них внутри графического процессора. Кроме того, графические карты, как правило, имеют большую площадь по сравнению с процессорами, что делает их достаточно просторными для размещения тысяч ядер CUDA.

Почему CUDA Core имеет значение в играх?

Теперь, когда вы знаете, что такое ядра CUDA и как они возникли, вы, вероятно, задаетесь вопросом, как все эти крошечные ядра могут улучшить ваши игровые возможности. Ядра CUDA позволяют вашему графическому процессору обрабатывать подобные задачи одновременно.

Эффективность ядер CUDA проистекает из этой функции параллельной обработки. Поскольку одно ядро работает для выполнения одной задачи, связанной с графикой, другое ядро рядом с ним выполнит аналогичную работу. Это исключает потерю времени, которое происходит, когда одно ядро ждет, пока другое выполнит свою задачу, прежде чем двигаться дальше.

Ядра CUDA только выполняют задачи, связанные с графикой, и именно здесь ядра CUDA выделяются из ядер ЦП. В то время как ядра ЦП работают для выполнения различных несвязанных задач, ядрам CUDA приходится беспокоиться только о графике.

Что касается вашего игрового опыта, ядра CUDA помогают сделать вашу игру реалистичной, предоставляя графику с высоким разрешением, которая создает реалистичный 3D-эффект. Вы также заметите, что ваши игры выглядят более детально и имеют улучшенное освещение и затенение.

Когда вы сталкиваетесь с экраном загрузки во время игр, знайте, что ядра CUDA работают за кулисами. Ядра CUDA создают пейзажи, рисуют модели персонажей и настраивают освещение, прежде чем отправиться в виртуальное приключение.

В чем разница между ядрами CUDA и потоковыми процессорами?

Если вы поклонник AMD, то, вероятно, вы знаете о потоковых процессорах AMD. Большинство людей знают потоковые процессоры как версию ядер CUDA от AMD, что по большей части верно.

Потоковые процессоры имеют то же назначение, что и ядра CUDA, но оба ядра работают по-разному. Ядра CUDA и потоковые процессоры определенно не равны друг другу — 100 ядер CUDA не эквивалентны 100 потоковым процессорам.

Итак, что же отличает потоковые процессоры от ядер CUDA? В основном это связано с тем, как построен графический процессор. Структура графических процессоров AMD и Nvidia сильно различается, и это приводит к тому, что ядра работают по-разному.

Сколько ядер CUDA вам действительно нужно?

Чем больше у вас ядер CUDA, тем лучше будет ваш игровой опыт. Однако, если вы ищете доступную видеокарту

6 лучших бюджетных видеокарт для дешевых игр

6 лучших бюджетных видеокарт для дешевых игр

Бюджетные видеокарты очень способны в наши дни. Вот лучшие бюджетные видеокарты, которые позволят вам играть по дешевке.

Прочитайте больше

Возможно, вы не захотите получить одно с большим количеством ядер CUDA (они могут быть довольно дорогими).

Ядра CUDA не просто популярны среди геймеров. Они имеют несколько различных применений в областях, которые имеют дело с огромным количеством данных, таких как инжиниринг и майнинг биткойнов. Вам понадобится большое количество ядер CUDA в этих областях, но сколько вам нужно, чтобы просто играть в компьютерную игру?

Ответ на самом деле зависит от того, сколько денег в вашем кошельке и насколько хорошо вы хотите свою видеокарту. При этом видеокарта с большим количеством ядер CUDA не обязательно означает, что она лучше, чем карта с меньшим числом. Качество видеокарты действительно зависит от того, как другие ее функции взаимодействуют с ядрами CUDA.

Чтобы получить точное сравнение между двумя картами, вы должны взглянуть на тесты производительности

10 лучших бесплатных тестовых программ для Windows

10 лучших бесплатных тестовых программ для Windows

Используйте это фантастическое и бесплатное тестовое программное обеспечение для Windows, чтобы устранить неполадки в вашей системе и поддерживать ее в актуальном состоянии.

Прочитайте больше

,

Заменят ли когда-нибудь графические процессоры?

Разработка ядер CUDA заставляет задуматься о том, может ли графический процессор полностью заменить процессор. Ядра CUDA способны вместить тысячи ядер, но достаточно ли этого для замены?

С начала 2000-х годов Nvidia работает над созданием графического процессора для общих вычислений. В 2003 году исследователи из Стэнфордского университета создали модель программирования под названием Brook, которая позволит Nvidia еще на шаг приблизиться к созданию универсального графического процессора. В то время некоторые люди думали, что внедрение Brook положит конец процессорам (как вы можете видеть, этого еще не произошло).

Лидер исследовательской группы, Ян Бак, в конце концов присоединился к Nvidia, начав рассказ о ядре CUDA. Nvidia выпустила CUDA в 2006 году, и с тех пор она доминирует в сфере глубокого обучения

Глубокое обучение против машинного обучения против искусственного интеллекта: как они идут вместе?

Глубокое обучение против машинного обучения против искусственного интеллекта: как они идут вместе?

Пытаетесь понять разницу между искусственным интеллектом, машинным обучением и глубоким обучением? Вот что они все значат.

Прочитайте больше

отрасли, обработка изображений, вычислительная наука и многое другое. Даже с развитием ядер CUDA маловероятно, что графические процессоры заменят процессоры.

Обновление вашей видеокарты

Использование видеокарты, оснащенной ядрами CUDA, даст вашему ПК преимущество в общей производительности, а также в играх. Больше ядер CUDA означает более четкую и реалистичную графику. Только не забудьте учесть и другие особенности видеокарты.

Если все элементы работают вместе для достижения наилучшей производительности, вы будете знать, что сделали правильный выбор.

Не знаете, с чего начать поиск следующей видеокарты? Наше руководство по покупке видеокарт

Лучшие видеокарты для любого бюджета

Лучшие видеокарты для любого бюджета

Найти высокопроизводительный бюджетный графический процессор может быть непросто. Мы собрали лучшие видеокарты для любого бюджета.

Прочитайте больше

поможет вам сделать осознанную покупку, которая соответствует вашему бюджету.

Как пиратская игра престолов и другие шоу могут принести вам вредоносное ПО

CUDA: Как работает GPU

Внутренняя модель nVidia GPU – ключевой момент в понимании GPGPU с использованием CUDA. В этот раз я постараюсь наиболее детально рассказать о программном устройстве GPUs. Я расскажу о ключевых моментах компилятора CUDA, интерфейсе CUDA runtime API, ну, и в заключение, приведу пример использования CUDA для несложных математических вычислений.

Вычислительная модель GPU:

При использовании GPU вы можете задействовать грид необходимого размера и сконфигурировать блоки под нужды вашей задачи.

CUDA и язык C:

Дополнительные типы переменных и их спецификаторы будут рассмотрены непосредственно в примерах работы с памятью.

CUDA host API:

Перед тем, как приступить к непосредственному использованию CUDA для вычислений, необходимо ознакомиться с так называемым CUDA host API, который является связующим звеном между CPU и GPU. CUDA host API в свою очередь можно разделить на низкоуровневое API под названием CUDA driver API, который предоставляет доступ к драйверу пользовательского режима CUDA, и высокоуровневое API – CUDA runtime API. В своих примерах я буду использовать CUDA runtime API.

Понимаем работу GPU:

Как было сказано, нить – непосредственный исполнитель вычислений. Каким же тогда образом происходит распараллеливание вычислений между нитями? Рассмотрим работу отдельно взятого блока.

Задача. Требуется вычислить сумму двух векторов размерностью N элементов.

Нам известна максимальные размеры нашего блока: 512*512*64 нитей. Так как вектор у нас одномерный, то пока ограничимся использованием x-измерения нашего блока, то есть задействуем только одну полосу нитей из блока (рис. 3).

Рис. 3. Наша полоса нитей из используемого блока.

Заметим, что x-размерность блока 512, то есть, мы можем сложить за один раз векторы, длина которых N // Функция сложения двух векторов

__global__ void addVector( float * left, float * right, float * result)

<

//Получаем id текущей нити.

int idx = threadIdx.x;

Таким образом, распараллеливание будет выполнено автоматически при запуске ядра. В этой функции так же используется встроенная переменная threadIdx и её поле x, которая позволяет задать соответствие между расчетом элемента вектора и нитью в блоке. Делаем расчет каждого элемента вектора в отдельной нити.

Пишем код, которые отвечает за 1 и 2 пункт в программе:

#define SIZE 512

__host__ int main()

<

//Выделяем память под вектора

float * vec1 = new float [SIZE];

float * vec2 = new float [SIZE];

float * vec3 = new float [SIZE];

//Инициализируем значения векторов

for ( int i = 0; i //Указатели на память видеокарте

float * devVec1;

float * devVec2;

float * devVec3;

…

dim3 gridSize = dim3(1, 1, 1); //Размер используемого грида

dim3 blockSize = dim3(SIZE, 1, 1); //Размер используемого блока

Теперь нам остаеться скопировать результат расчета из видеопамяти в память хоста. Но у функций ядра при этом есть особенность – асинхронное исполнение, то есть, если после вызова ядра начал работать следующий участок кода, то это ещё не значит, что GPU выполнил расчеты. Для завершения работы заданной функции ядра необходимо использовать средства синхронизации, например event’ы. Поэтому, перед копированием результатов на хост выполняем синхронизацию нитей GPU через event.

Код после вызова ядра:

//Выполняем вызов функции ядра

addVector >>(devVec1, devVec2, devVec3);

//Хендл event’а

cudaEvent_t syncEvent;

cudaEventCreate(&syncEvent); //Создаем event

cudaEventRecord(syncEvent, 0); //Записываем event

cudaEventSynchronize(syncEvent); //Синхронизируем event

Рассмотрим более подробно функции из Event Managment API.

Рис. 4. Синхронизация работы основоной и GPU прграмм.

На рисунке 4 блок «Ожидание прохождения Event’а» и есть вызов функции cudaEventSynchronize.

Ну и в заключении выводим результат на экран и чистим выделенные ресурсы.

cudaFree(devVec1);

cudaFree(devVec2);

cudaFree(devVec3);

Думаю, что описывать функции высвобождения ресурсов нет необходимости. Разве что, можно напомнить, что они так же возвращают значения cudaError_t, если есть необходимость проверки их работы.

Заключение

Надеюсь, что этот материал поможет вам понять, как функционирует GPU. Я описал самые главные моменты, которые необходимо знать для работы с CUDA. Попробуйте сами написать сложение двух матриц, но не забывайте об аппаратных ограничениях видеокарты.

Знакомство с программно-аппаратной архитектурой CUDA

Поговорим о том, что такое CUDA, как эта технология связана с NVIDIA и как ускоряет обработку данных вычислительной техникой.

Сложность вычислительных заданий требует резкого увеличения ресурсов и скорости компьютеров. Наиболее перспективным направлением повышения скорости решения задач является внедрение идей параллелизма в работу вычислительных систем.

Сегодня спроектированы и испытаны сотни различных компьютеров, которые используют в своей архитектуре тот или иной вид параллельной обработки данных. Основная сложность при проектировании параллельных программ – обеспечение правильной последовательности взаимодействия между разными вычислительными процессами, а также координация ресурсов, которые разделяются между ними.

Поговорим о CUDA

CUDA – это программно-аппаратная архитектура параллельных вычислений, позволяющая существенно увеличить вычислительную продуктивность благодаря использованию графических процессоров NVIDIA.

При использовании данной технологии необходимо знать следующие понятия:

CUDA позволяет программистам реализовывать на специальном упрощенном диалекте языка C алгоритмы, которые используются в графических процессорах NVIDIA, и включать специальные функции в текст программы на C.

«Архитектура CUDA позволяет разработчику на свое усмотрение организовывать доступ к набору инструкций GPU и управлять его памятью.»

Эта технология поддерживает несколько языков программирования. Среди них Java, Python и некоторые другие.

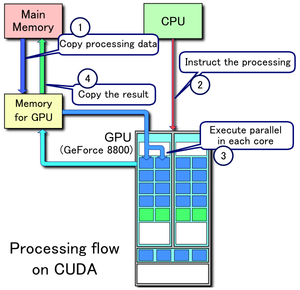

Этапы запуска программы на GPU или как все происходит

Рассмотрим, как происходит запуск программы на графическом процессоре:

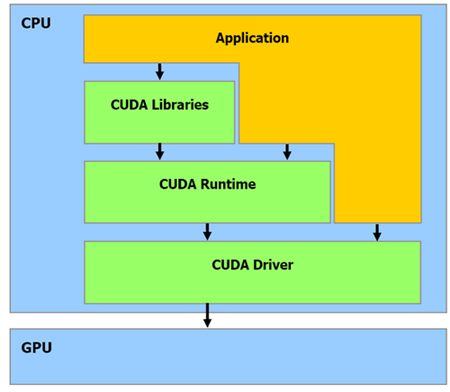

На рисунке изображены все перечисленные шаги запуска программы, кроме первого (источник).

Как видно из рисунка, центральный процессор взаимодействует с графическим через CUDA Runtime API, CUDA Driver API и CUDA Libraries. Runtime и Driver API отличаются уровнем абстракции. Грубо говоря, первый вариант более высокого уровня в плане программирования, более абстрактный, а второй – напротив, более низкого (уровень драйвера).

В целом Runtime API является абстрактной оберткой Driver API. Во время программирования вы можете использовать любой из представленных вариантов. Из личного опыта: при использовании Driver API нужно написать немного «лишнего» кода + данный вариант сложнее.

Также необходимо понять одну важную вещь, которая впоследствии сэкономит вам время и нервы:

«Если отношение времени, потраченного на работу ядер, окажется меньше времени, потраченного на выделение памяти и запуск этих ядер, вы получите нулевую эффективность от использования GPU.»

Давайте разберем написанное подробнее. Чтобы запустить некоторые задачи на GPU, необходимо потратить «немного» времени на выделение памяти, копирование результата, etc., поэтому не нужно выполнять на графическом процессоре легкие задания, которые на деле занимают буквально миллисекунды. Зачем выполнять на GPU то, с чем легко, а главное, быстрее справится центральный процессор?

У вас возникнет вопрос: «Тогда зачем вообще использовать GPU, если при этом приходится тратить драгоценное время на выделение памяти и другие ненужные вещи?». Это заблуждение, и со временем вы поймете, что CUDA – действительно мощная технология. Дальше разберемся, почему это так.

Аппаратная часть

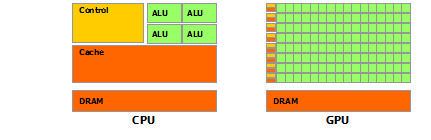

Архитектура GPU построена несколько иначе, нежели CPU. Поскольку графические процессоры сперва использовались только для графических расчетов, которые допускают независимую параллельную обработку данных, то GPU и предназначены именно для параллельных вычислений. Он спроектирован таким образом, чтобы выполнять огромное количество потоков (элементарных параллельных процессов).

Как видно из картинки – в GPU есть много простых арифметически-логических устройств (АЛП), которые объединены в несколько групп и обладают общей памятью. Это помогает повысить продуктивность в вычислительных заданиях, но немного усложняет программирование.

«Для достижения лучшего ускорения необходимо продумывать стратегии доступа к памяти и учитывать аппаратные особенности.»

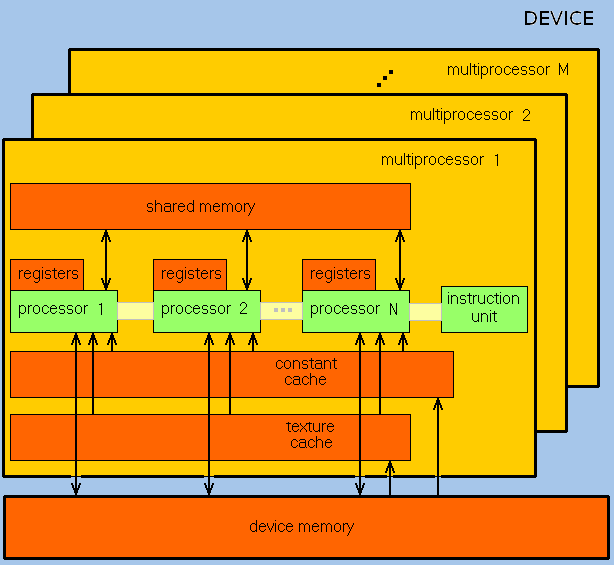

GPU ориентирован на выполнение программ с большим объемом данных и расчетов и представляет собой массив потоковых процессоров (Streaming Processor Array), что состоит из кластеров текстурных процессоров (Texture Processor Clusters, TPC). TPC в свою очередь состоит из набора мультипроцессоров (SM – Streaming Multi-processor), в каждом из которых несколько потоковых процессоров (SP – Streaming Processors) или ядер (в современных процессорах количество ядер превышает 1024).

Набор ядер каждого мультипроцессора работает по принципу SIMD (но с некоторым отличием) – реализация, которая позволяет группе процессоров, работающих параллельно, работать с различными данными, но при этом все они в любой момент времени должны выполнять одинаковую команду. Говоря проще, несколько потоков выполняют одно и то же задание.

В результате GPU фактически стал устройством, которое реализует потоковую вычислительную модель (stream computing model): есть потоки входящих и исходящих данных, что состоят из одинаковых элементов, которые могут быть обработаны независимо друг от друга.

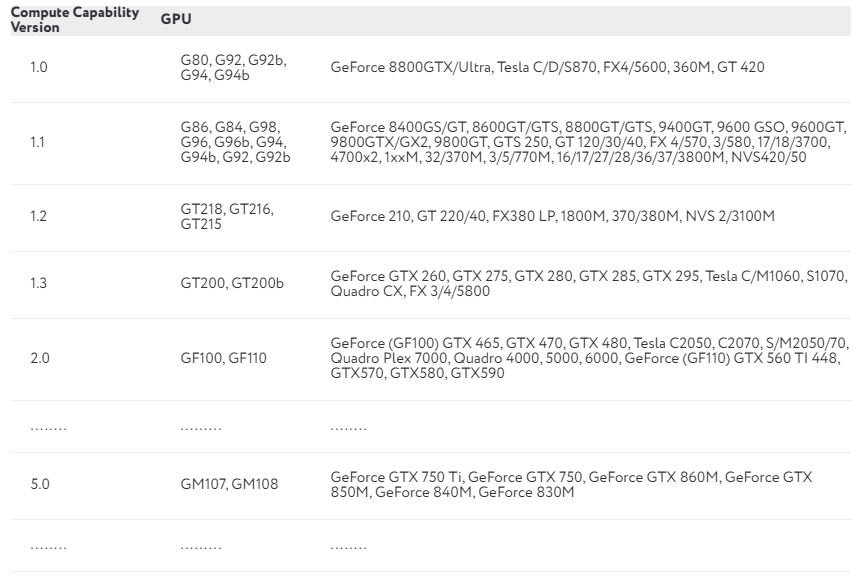

Вычислительные возможности

Продолжаем разбираться с CUDA. Каждая видеокарта обладает так называемыми compute capabilities – количественными характеристиками скорости выполнения определенных операций на графическом процессоре. Данное число показывает, насколько быстро видеокарта будет выполнять свою работу.

В NVIDIA эту характеристику обозначают Compute Capability Version. В таблице приведены некоторые видеокарты и соответствующие им вычислительные возможности:

Полный перечень можно посмотреть здесь. Compute Capability Version описывает множество параметров, среди которых: количество потоков на блок, максимальное количество блоков и потоков, размер warp, а также многое другое.

Потоки, блоки и сетки

CUDA использует большое количество отдельных потоков для расчетов. Все они группируются в иерархию – grid / block / thread.

Верхний уровень – grid – отвечает ядру и объединяет все потоки, которые выполняет данное ядро. Grid – одномерный или двумерный массив блоков (block). Каждый блок (block) представляет собой полностью независимый набор скоординированных между собой потоков. Потоки из разных блоков не могут взаимодействовать.

Мы упоминали об отличии от SIMD-архитектуры. Есть такое понятие, как warp – группа из 32 потоков (в зависимости от архитектуры GPU, но почти всегда 32). Только потоки в рамках одной группы (warp) могут физически выполняться одновременно. Потоки разных варпов могут находиться на разных стадиях выполнения программы. Такой метод обработки данных обозначается термином SIMT (Single Instruction – Multiple Theads). Управление работой варпов выполняется на аппаратном уровне.

Почему иногда центральный процессор выполняет задания быстрее графического?

Выше уже было написано, что не стоит выполнять на GPU слишком простые задания. Чтобы понять, следует определить два термина:

Таким образом, главный вопрос состоит в следующем: почему графический процессор иногда «тупит»? Объясняем на простом примере.

У нас есть 2 автомобиля:

Если одна операция – это передвижение одного человека на определенное расстояние (пусть будет 1 км), то задержка (время, за которое один человек пройдет 1 км) для первого авто составит 3600/120 = 30 сек, а пропускная способность – 9/30 = 0,3. Для автобуса – 3600/90 = 40 сек и 30/40 = 0,75.

CPU – это фургон, а GPU – автобус: у него большая задержка, но также и большая пропускная способность. Если для вашего задания задержка каждой конкретной операции не так важна, как количество этих самых операций в секунду, то стоит рассмотреть использование GPU.

Выводы

Отличительными чертами GPU в сравнении с CPU являются:

Главный минус CUDA в том, что данная технология поддерживается только видеокартами NVIDIA без каких-либо альтернатив.

Графический процессор не всегда может дать ускорение при выполнении определенных алгоритмов. Поэтому перед использованием GPU для вычислений стоит хорошо подумать, а нужен ли он в данном случае. Вы можете использовать видеокарту для сложных вычислений: работа с графикой или изображениями, инженерные расчеты, криптографические задачи (майнинг), и т. д., но не используйте GPU для решения простых задач (разумеется, вы можете, но тогда эффективность будет равняться нулю).

Помните о задаче с фургоном и автобусом, а также не забывайте, что использование графического процессора гораздо вероятнее замедлит программу, нежели ускорит ее.

Вас также могут заинтересовать такие материалы по теме:

Нужны ли графические ядра Nvidia CUDA для игр?

Ядра CUDA являются эквивалентом процессорных ядер Nvidia. Они оптимизированы для одновременного выполнения большого количества вычислений, что очень важно для современной графики. Естественно, на графические настройки больше всего повлияло количество ядер CUDA в видеокарте, и они требуют больше всего от графического процессора, то есть теней и освещения, среди прочего.

CUDA долгое время была одной из самых выдающихся записей в спецификациях любой видеокарты GeForce. Однако не все до конца понимают, что такое ядра CUDA и что конкретно они означают для игр.

В этой статье дан краткий и простой ответ на этот вопрос. Кроме того, мы кратко рассмотрим некоторые другие связанные вопросы, которые могут возникнуть у некоторых пользователей.

Что такое ядра видеокарты CUDA?

CUDA является аббревиатурой от одной из запатентованных технологий Nvidia: Compute Unified Device Architecture. Его цель? Эффективные параллельные вычисления.

Одиночное ядро CUDA аналогично ядру ЦП, основное отличие в том, что оно менее изощренное, но реализовано в большем количестве. Обычный игровой процессор имеет от 2 до 16 ядер, но количество ядер CUDA исчисляется сотнями, даже в самых низких современных видеокартах Nvidia GeForce. Между тем, у высококлассных карт сейчас их тысячи.

Что делают ядра CUDA в играх?

Обработка графики требует одновременного выполнения множества сложных вычислений, поэтому такое огромное количество ядер CUDA реализовано в видеокартах. И учитывая, как графические процессоры разрабатываются и оптимизируются специально для этой цели, их ядра могут быть намного меньше, чем у гораздо более универсального CPU.

И как ядра CUDA влияют на производительность в игре?

По сути, любые графические настройки, которые требуют одновременного выполнения вычислений, значительно выиграют от большего количества ядер CUDA. Наиболее очевидными из них считается освещение и тени, но также включены физика, а также некоторые типы сглаживания и окклюзии окружающей среды.

Ядра CUDA или потоковые процессоры?

Там, где у Nvidia GeForce есть ядра CUDA, у их основного конкурента AMD Radeon есть потоковые процессоры.

Ядра CUDA лучше оптимизированы, поскольку аппаратное обеспечение Nvidia обычно сравнивают с AMD, но нет никаких явных различий в производительности или качестве графики, о которых вам следует беспокоиться, если вы разрываетесь между приобретением Nvidia или AMD GPU.

Сколько ядер CUDA вам нужно?

И вот сложный вопрос. Как часто бывает с бумажными спецификациями, они просто не являются хорошим индикатором того, какую производительность вы можете ожидать от аппаратного обеспечения.

Многие другие спецификации, такие как пропускная способность VRAM, более важны для рассмотрения, чем количество ядер CUDA, а также вопрос оптимизации программного обеспечения.

Для общего представления о том, насколько мощен графический процессор, мы рекомендуем проверить UserBenchmark. Однако, если вы хотите увидеть детальное и всестороннее тестирование, есть несколько надежных сайтов, таких как GamersNexus, TrustedReviews, Tom’s Hardware, AnandTech и ряд других.

Вывод

Надеемся, что это помогло пролить некоторый свет на то, чем на самом деле являются ядра CUDA, что они делают и насколько они важны. Прежде всего, мы надеемся, что помогли развеять любые ваши заблуждения по этому поводу.